��(d��ng)ǰλ�ã����(y��) > �W(xu��)��(x��)�YԴ > �v������ > ��ͬ�����(sh��)��(du��)��(j��ng)�W(w��ng)�j(lu��)���ܵ�Ӱ�

��ͬ�����(sh��)��(du��)��(j��ng)�W(w��ng)�j(lu��)���ܵ�Ӱ�

�r(sh��)�g��2024-12-12 ��(l��i)Դ���A���h(yu��n)Ҋ(ji��n)

��ͬ�����(sh��)��(du��)��(j��ng)�W(w��ng)�j(lu��)���ܵ�Ӱ�

�r(sh��)�g��2024-12-12 ��(l��i)Դ���A���h(yu��n)Ҋ(ji��n)

���ԣ�

����(j��ng)�W(w��ng)�j(lu��)���O(sh��)Ӌ(j��)�У������(sh��)���������P(gu��n)��Ҫ�Ľ�ɫ�������Q������(j��ng)Ԫ��ݔ������f���W(w��ng)�j(lu��)����һ�ӣ��M(j��n)��Ӱ푵�����(g��)�W(w��ng)�j(lu��)�ı��F(xi��n)�����ܡ��x����m�ļ����(sh��)���H�����ģ�͵Ĝ�(zh��n)�_�ȣ�߀�ܼ���Ӗ(x��n)���^(gu��)�̡���ˣ��˽ⲻͬ�����(sh��)�����c(di��n)���䌦(du��)��(j��ng)�W(w��ng)�j(lu��)���ܵ�Ӱ�����ȌW(xu��)��(x��)�е�һ��(g��)��Ҫ�n�}��

1. �����(sh��)�Ļ�������

�����(sh��)����(j��ng)�W(w��ng)�j(lu��)�еķǾ��Ժ���(sh��)��������һ��(g��)ݔ��ֵ����ݔ��һ��(g��)̎���^(gu��)��ֵ���](m��i)�м�,���(sh��)����(j��ng)�W(w��ng)�j(lu��)���ஔ(d��ng)��һ��(g��)����ģ�ͣ��o(w��)����Ч���M(j��n)�Џ�(f��)�s��ģʽ�W(xu��)��(x��)���������(sh��)�ķǾ����������S��(j��ng)�W(w��ng)�j(lu��)�W(xu��)��(x��)����(f��)�s��ģʽ��

��Ҋ(ji��n)�ļ����(sh��)����:Sigmoid��Tanh��ReLU��Leaky ReLU��ELU�ȣ�ÿ�N�����(sh��)�����䃞(y��u)ȱ�c(di��n)���m�È�(ch��ng)����

2. ��Ҋ(ji��n)�����(sh��)�������c(di��n)

2.1 Sigmoid ����(sh��)

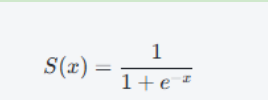

Sigmoid ����(sh��)�Ĕ�(sh��)�W(xu��)���_(d��)ʽ��:

����ݔ��������(0,1)��ʹ��ɞ�һ�N����ݔ������(sh��)��ͨ�����ڶ����(w��n)�}��ݔ���ӡ�Ȼ����Sigmoid ����(sh��)����һЩȱ�c(di��n):

l �ݶ���ʧ��(w��n)�}:��(d��ng)ݔ��ֵ�dz����dz�С�r(sh��)��Sigmoid �Č�(d��o)��(sh��)�ӽ���0���@��(hu��)��(d��o)���ݶ���ʧ���M(j��n)��ʹ��Ӗ(x��n)��׃������ͣ����

l ݔ���������ֵ:Sigmoid ݔ����ֵ������(0,1)֮�g���@ʹ�Ã�(y��u)���^(gu��)��׃�ø������y��

2.2 Tanh ����(sh��)

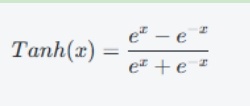

Tanh ����(sh��)(�p�����к���(sh��))�� siqmoid ����(sh��)�ĔU(ku��)չ������ݔ��������(-1,1)�����Ҿ��и��õ��ݶ����|(zh��)���䔵(sh��)�W(xu��)���_(d��)ʽ��:

Tanh ����(sh��)�ă�(y��u)�c(di��n)����:

l ���ֵݔ��:Tanh ��ݔ��������(-1,1)���@ʹ�þW(w��ng)�j(lu��)��Ӗ(x��n)�����ӷ�(w��n)����

l �^�ٵ��ݶ���ʧ��(w��n)�}:���^�� Sigmoid��Tanh ���^����ݔ��r(sh��)�����ṩ�^��(qi��ng)���ݶȣ��������ݶ���ʧ��Ӱ푡�

Ȼ����Tanh ����(sh��)Ҳ������ƵĆ�(w��n)�}:����ݔ����Ȼ��͵ģ���(d��o)���ژO��ֵ�r(sh��)��(hu��)�l(f��)���ݶ���ʧ��

2.3 ReLU ����(sh��)

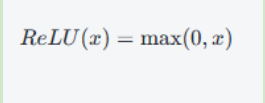

ReLU(Rectified Linear Unit���������Ԇ�Ԫ)��Ŀǰ��ȌW(xu��)��(x��)����õļ����(sh��)֮-

�䔵(sh��)�W(xu��)���_(d��)ʽ��:

ReLu �ă�(y��u)�c(di��n)����:

l Ӌ(j��)�㺆(ji��n)��:RelU ����(sh��)�dz���(ji��n)�Σ�Ӌ(j��)��Ч�ʸߡ�

l �����ݶ���ʧ:ReLU �������S�Ͼ��г���(sh��)�ݶȣ��������ݶ���ʧ��(w��n)�}�������m���������(j��ng)�W(w��ng)�j(lu��)��

l ϡ����:���� ReLU ��ؓ(f��)���Sݔ����0��������ϡ���ԣ�ʹ����(j��ng)�W(w��ng)�j(lu��)���Ӹ�Ч��

Ȼ����ReLU Ҳ��һ��(g��)��(w��n)�}����(j��ng)Ԫ��(w��n)�}����(d��ng)ݔ��С����r(sh��)��ReLU ݔ����0�����܌�(d��o)��һЩ��(j��ng)Ԫ��ݔ��ʼ�K���㣬�@Щ��(j��ng)Ԫ���ٸ��£��o(w��)�����cӖ(x��n)����

2.4 Leaky ReLU �� Parametric ReLU

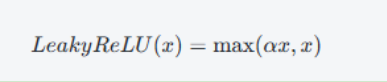

���˾��� ReLU ������(j��ng)Ԫ��(w��n)�}��Leaky ReLU ��������䔵(sh��)�W(xu��)��ʽ��:

���У�a��һ��(g��)�dz�С�ij���(sh��)��ͨ��ȡֵ�� 0.01��Leaky Relu ��ؓ(f��)�S�ϲ���(hu��)��ȫ׃?y��u)?0�����ǽo��һ��(g��)С��ؓ(f��)ֵ���Ķ���������(j��ng)Ԫ"����"��(w��n)�}Parametric RelU(PReLU)�� Leaky Rel ��һ��(g��)�U(ku��)չ������ α �ǿɌW(xu��)��(x��)�ą���(sh��)��ͨ�^(gu��)Ӗ(x��n)����PReLU �������m��(y��ng)���x������m��ؓ(f��)б�ʡ�

2.5 ELU ����(sh��)

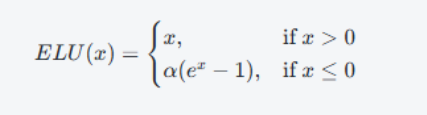

ELU(Exponential Linear Unit)����һ�N������ļ����(sh��)����ʽ��:

ELU �ă�(y��u)�c(di��n)��:

l �����ݶ���ʧ��(w��n)�}:�c ReLU ��ƣ�ELU �������S�к㶨���ݶȣ�����ؓ(f��)���S��ݔ��ͨ�^(gu��)ָ��(sh��)����(sh��)�M(j��n)��ƽ���^(gu��)�ɡ�

l ����Ӗ(x��n)���ٶ�:����� ReLU��ELU ��ؓ(f��)���S����ؓ(f��)ֵ������ʹ�þW(w��ng)�j(lu��)��Ӗ(x��n)���^(gu��)�����и��õ��Ք��ԡ�

ELU ��ȱ�c(di��n)��Ӌ(j��)���(f��)�s���^�ߣ��Ү�(d��ng)�� ���x��(d��ng)�r(sh��)�����ܕ�(hu��)��(d��o)��Ӗ(x��n)������(w��n)����

1. �����(sh��)���x��(du��)���ܵ�Ӱ�

��ͬ�ļ����(sh��)��(du��)����(j��ng)�W(w��ng)�j(lu��)�������в�ͬ��Ӱ푣����w�w�F(xi��n)�����ׂ�(g��)����:

l �Ք��ٶ�:RelU ����׃�N(�� Leaky ReLU��PReU��ELU)���ڱ������ݶ���ʧ��(w��n)�}��ͨ�����и�����Ք��ٶȡ�����sigmoid ��Tanh ���������ݶ���ʧ���ݶ�ͣ���(d��o)��Ӗ(x��n)��׃����

l ��(zh��n)�_��:�ںܶ��΄�(w��)�У�ReLU ��ELU �ı��F(xi��n)������(y��u)�� sigmoid�� Tnh����������̎���^��ľW(w��ng)�j(lu��)�r(sh��)��Rel ͨ���܉��ṩ���ߵĜ�(zh��n)�_�Ⱥ��õķ���������

l �ݶ���ʧ���}:sigmoid �� anh����(sh��)�������^���ݔ��ֵ�³��F(xi��n)�ݶ���ʧ��(w��n)�}���@ʹ������?c��)���ȾW(w��ng)�j(lu��)�б��F(xi��n)�^�ReU �� ELU �Ⱥ���(sh��)�܉��@һ��(w��n)�}���e������ȾW(w��ng)�j(lu��)��Ӗ(x��n)���б��F(xi��n)���鷀(w��n)����

l �Ǿ����cϡ����:ReL ��ϡ����ʹ����W(w��ng)�j(lu��)��̎��ijЩ�΄�(w��)�r(sh��)���Ѓ�(y��u)��(sh��)���������ڴ�Ҏ(gu��)ģ��(sh��)��(j��)���ϣ��܉���Ч�p�pӋ(j��)��ؓ(f��)��(d��n)��

2. �Y(ji��)Փ

�x����m�ļ����(sh��)��(du��)����(j��ng)�W(w��ng)�j(lu��)���������P(gu��n)��Ҫ����(du��)�ڴ����(sh��)�F(xi��n)����ȌW(xu��)��(x��)ģ�ͣ�RelU ����׃�N(LeakyRU��ELU��PReLU)ͨ������õ��x����?y��n)���������Ч�����ݶ���ʧ�?w��n)�}������Ӗ(x��n)���ٶ��^�졣Ȼ����ᘌ�(du��)�ض��΄�(w��)�͔�(sh��)��(j��)��������Ҫ�M(j��n)��һ���Č�(sh��)�(y��n)���{(di��o)�����x�����m�ϵļ����(sh��)���S���о������룬δ��(l��i)���ܕ�(hu��)���F(xi��n)�����µļ����(sh��)���Ը��õؽ�Q�F(xi��n)�з�����ȱ�c(di��n)�;����ԡ�

�ژ�(g��u)����Ӗ(x��n)����(j��ng)�W(w��ng)�j(lu��)�r(sh��)�����⼤���(sh��)�����ԡ���(y��u)ȱ�c(di��n)���Լ�����?n��i)��Ӱ�ģ�͵����ܣ���ÿ��(g��)��ȌW(xu��)��(x��)�ĘI(y��)�߲��ɺ�ҕ����Ҫ�h(hu��n)��(ji��)��

�n�̷������A���h(yu��n)Ҋ(ji��n)(li��n)��NXP�Ƴ�i.MX8M Plus�_(k��i)�l(f��)�c��(sh��)�`

�n�̷������A���h(yu��n)Ҋ(ji��n)(li��n)��NXP�Ƴ�i.MX8M Plus�_(k��i)�l(f��)�c��(sh��)�` �n�̷���������HarmonyOSϵ�y(t��ng)����(li��n)�W(w��ng)�_(k��i)�l(f��)��(sh��)��(zh��n)�n�̣�

�n�̷���������HarmonyOSϵ�y(t��ng)����(li��n)�W(w��ng)�_(k��i)�l(f��)��(sh��)��(zh��n)�n�̣� �n�̷�����HaaS EDU K1�_(k��i)�l(f��)�̳̣����n��ҕ�l��Դ�a��

�n�̷�����HaaS EDU K1�_(k��i)�l(f��)�̳̣����n��ҕ�l��Դ�a�� �°�C�Z(y��)�Ծ���֮�����Z(y��)��ҕ�l�̳��ذ�ٛ(z��ng)�ͣ�Ƕ��ʽ��

�°�C�Z(y��)�Ծ���֮�����Z(y��)��ҕ�l�̳��ذ�ٛ(z��ng)�ͣ�Ƕ��ʽ�� �r(ji��)ֵ2000Ԫ��Ƕ��ʽ���b�̴̳�Y�����M(f��i)�ͣ����㶮Ƕ��

�r(ji��)ֵ2000Ԫ��Ƕ��ʽ���b�̴̳�Y�����M(f��i)�ͣ����㶮Ƕ�� �r(ji��)ֵ1000Ԫ������ARMϵ��ҕ�l������̳����r���t����

�r(ji��)ֵ1000Ԫ������ARMϵ��ҕ�l������̳����r���t���� �����¡�ARM�n���n�Ì�(sh��)䛾��A��ҕ�l���M(f��i)�I(l��ng)ȡ����(n��i)��Դ

�����¡�ARM�n���n�Ì�(sh��)䛾��A��ҕ�l���M(f��i)�I(l��ng)ȡ����(n��i)��Դ ������ÙC(j��)���W(xu��)��(x��)��(g��u)����(g��)�Ի����]ϵ�y(t��ng)

������ÙC(j��)���W(xu��)��(x��)��(g��u)����(g��)�Ի����]ϵ�y(t��ng) Ƕ��ʽϵ�y(t��ng)����늵�����ϵ�y(t��ng)�\(y��n)�е���������(d��ng)����

Ƕ��ʽϵ�y(t��ng)����늵�����ϵ�y(t��ng)�\(y��n)�е���������(d��ng)���� ����ڲ�ͬ������(ch��ng)����(y��u)��Ƕ��ʽϵ�y(t��ng)���Դ����

����ڲ�ͬ������(ch��ng)����(y��u)��Ƕ��ʽϵ�y(t��ng)���Դ���� Ӳ������ӣ�HAL�����O(sh��)Ӌ(j��)�����ߴ��a�Ŀ���ֲ��

Ӳ������ӣ�HAL�����O(sh��)Ӌ(j��)�����ߴ��a�Ŀ���ֲ�� �����wһ������ȌW(xu��)��(x��)Ӗ(x��n)���е����ú͌�(sh��)�F(xi��n)����

�����wһ������ȌW(xu��)��(x��)Ӗ(x��n)���е����ú͌�(sh��)�F(xi��n)���� ��(li��n)�W(w��ng)�(xi��ng)Ŀ���O(sh��)Ӌ(j��)Ƕ��ʽϵ�y(t��ng)�r(sh��)���P(gu��n)�I���g(sh��)�Ϳ��]����

��(li��n)�W(w��ng)�(xi��ng)Ŀ���O(sh��)Ӌ(j��)Ƕ��ʽϵ�y(t��ng)�r(sh��)���P(gu��n)�I���g(sh��)�Ϳ��]���� ͨ�^(gu��)��Ȼ�Z(y��)��̎�����g(sh��)�����ı�����Ӻ��x

ͨ�^(gu��)��Ȼ�Z(y��)��̎�����g(sh��)�����ı�����Ӻ��x ��λ���RISC-V�ܘ�(g��u)�O(sh��)Ӌ(j��)��Ч�ܵ�Ƕ��ʽϵ�y(t��ng)

��λ���RISC-V�ܘ�(g��u)�O(sh��)Ӌ(j��)��Ч�ܵ�Ƕ��ʽϵ�y(t��ng) LSTM��GRU�ڕr(sh��)�g�����A(y��)�y(c��)�еđ�(y��ng)��

LSTM��GRU�ڕr(sh��)�g�����A(y��)�y(c��)�еđ�(y��ng)�� JTAG��SWD���{(di��o)ԇ���g(sh��)����(y��ng)��

JTAG��SWD���{(di��o)ԇ���g(sh��)����(y��ng)��